Nós somos a transformação digital da pesquisa

Saia do mundo ad-hoc e venha para o mundo de dados e big-data para diariamente entender sua concorrência e seus consumidores. Integre, em tempo real, dados altamente perfilados e geolocalizados aos seus processos de inteligência.

Checagem in-loco

Colete informações em fotos, vídeos e/ou formulários em PDVs e combine com dados perfilados do consumidor com coleta geolocalizada rápida e em volume, em mais de 4700 cidades brasileiras.

Inteligência competitiva de aplicativos

Colete, em volume, escala e em tempo real, os dados que ninguém alcança de outros aplicativos e/ou concorrentes.

Desempenho de Mídia

Teste, melhore e comprove com base neurocientífica a efetividade de gastos milionários em inserções publicitárias em comerciais, programas e inserções em TV, streaming e/ou Youtube.

Doe e ajude nossos 3 milhões de usuários a recolher lixo nas praias em todo o Brasil

Colete informações nos PDVs sob a perspectiva do consumidor

Tenha fotos, vídeos e formulários em volume sobre um ponto de venda ou local que seja de interesse ao seu negócio com nossa base de mais de 3 MILHÕES de usuários espalhados em mais de 4.700 municípios em todo o Brasil.

Use o melhor da pesquisa aliada à experiência real do consumidor, inteligência competitiva geolocalizada e dados em escala.

Tenha dados em tempo real da concorrência em aplicativos

Quais dados do seu concorrente e do seu consumidor no concorrente fariam diferença em sua estratégia e inteligência de mercado se você os tivesse em volume e tempo real?

Preços? Promoções? Meios de pagamento? Avaliações? Tempo de uso?

Descubra o que podemos fazer por você, tudo dentro da LGPD (Lei Geral de Proteção de Dados).

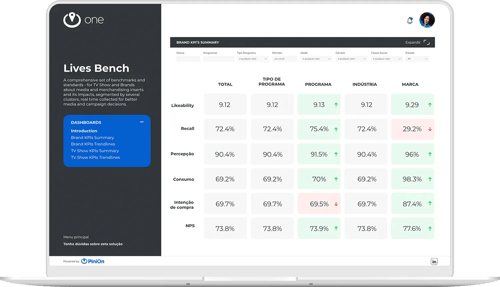

Meça a efetividade da sua inserção em mídia

Junte-se ao maior grupo de mídia do Brasil e com nossa solução VIEWS avalie uma peça criativa de forma ágil e com toda base neurocientífica.

Ou, com nossa solução LIVES, entenda AO VIVO a resposta da audiência às suas inserções publicitárias em programas de TV, streaming ou Youtube.

Com isso você têm dados quantitativos e qualitativos para aprender, comprovar e melhorar constantemente a performance das suas inserções em mídia.

CLIQUE PARA SABER MAIS:

Valeu o risco?

Aplicamos o VIEWS, uma das nossas soluções de desempenho de mídia, na campanha que deu o que falar da Volkswagem do Brasil, no começo de julho 2023.

Descubra na prática como funciona nossa metodologia e quais dados geramos com nossa plataforma

MasterChef & Pão de Açúcar

Aplicamos o Lives Pocket, nossa solução que traz indicadores sobre atratividade de programas em vídeo, como também a percepção da audiência sobre as propagandas e inserções de anunciantes.

Explore o universo PiniOn com conhecimentos valiosos que te ajudarão a tomar decisões estratégicas baseadas no seu consumidor!

-

"O PiniOn vem nos ajudando muito no caminho de evolução da Globo como uma MediaTech. Nos últimos anos, através das suas soluções de coleta de dados com alto volume e entregas em tempo real, conseguimos atingir um entendimento incrível de mercado suportando nossos clientes, times de estratégia e vendas."

Nino da Silva

Ger. de Criação e Desenv. de Serviços - Globo -

"Aqui na DM9 contamos com as soluções do PiniOn para mapear e coletar dados de mercado com agilidade e eficiência. Nossa parceria tem sido fundamental para a geração de insights acionáveis para o processo criativo tanto dentro da agência, quanto para nossos clientes."

Catarina Moraes

Head de Empatia - DM9 -

"Sou testemunha da evolução da empresa, que oferece hoje uma das ferramentas de coleta de dados mais importantes e ágeis do mercado. Lá, encontramos uma equipe comprometida, pronta para abraçar novos desafios. O resultado disso é abertura e ação para evoluirmos e inovarmos juntos."

Milena Vital

Ger. de Consumer & Market Insights - CNN Brasil -

"O PiniOn tem a capacidade de coletar dados com agilidade para tomada de decisões estratégicas. Tornou-se uma importante ferramenta em nossa rotina de pesquisa com consumidores."

Ivo Costa

Ger. de Insights e Marca - Grupo SBF / Centauro -

"O PiniOn tem sido um grande parceiro da Associação Comercial de São Paulo nos últimos anos, elaborando índices de confiança do consumidor e pesquisas de intenção de compra. Esses dados, além de permitir uma melhor compreensão da dinâmica do varejo, têm contribuído para melhorar a capacidade de previsão das vendas do comércio."

Ulisses Ruiz

Economista - Associação Comercial de São Paulo

Como funciona o processo?

Pre-Designed Missions

Pre-Designed Missions

Fill the blanks | Files upload

Fill the blanks | Files upload

Profile | Audience Selection

Profile | Audience Selection

Data Processing

Data Processing

2. Data Processing

2. Data Processing

3. Data Structure

3. Data Structure

Nossa história

Fundado em 2012, o PiniOn se tornou a maior plataforma brasileira de realização de missões virtuais e presenciais.

Pulverizado no país inteiro, contamos com mais de 3 milhões de usuários cadastrados e estamos presentes em mais de 4,5 mil cidades.

Hoje, coordenamos tarefas em escala para empresas, governos e para o terceiro setor, melhorando a eficiência dos negócios e informações ao realizar ações de forma ágil e com resultados auditáveis.

Diferenciais do PiniOn

Para empresas.

Geolocalização

Latitude e Longitude com coordenadas em 8 dígitos de precisão.

Perfilamento

Milhares de segmentações existentes e outras customizáveis possíveis.

Alcance

Estamos em mais de 4,5 mil municípios, 98% da população e 99% do PIB Nacional.

Volume de Dados

+ de 10MM de missões no ano, uma missão a cada 3 segundos em média e milhares de usuários ativos todos os dias.

Multimídia

Uso de multimídia (Foto, Áudio, Vídeo, Emojis etc) para orientar e/ou ser alvo da coleta, melhorando assertividade e qualidade dos dados.

Tempo Real

O dado é sistematicamente programado para ser coletado a qualquer hora, em qualquer dia (24x7) e é transmitido ao vivo para o cliente.

Reconhecimento de Imagem

Milhares de dados de imagem processados e estruturados em segundos.

Enriquecimento de dados

Enriquecemos a sua base de dados, fornecendo dados estruturados adicionais ou validando em campo quaisquer informações.

API

API para solicitações e entrega de dados, ou conectada ao seu marketplace.

Para opiners.

Missões engajadoras

Envolva-se dentro de casa ou na sua comunidade.

Trilhas educacionais

Aprenda, faça a diferença e receba por isso.

Ajuda à comunidade

Participe de ações que farão a diferença para todos.

Renda extra

Ganhe dinheiro completando missões com o seu celular.

Aprender é divertido

Com gamificação, seu conteúdo educacional se torna divertido e interativo para os Opiners.

Conscientização

Tenha a chance de participar de grandes ações de impacto ambiental e social.

Saia da rotina

Seja virtual ou localmente, uma missão nunca é igual a outra.

Saque com PIX

Ao acumular R$25, solicite o saque diretamente do app para sua conta via PIX.

Aumente a escala, verifique e digitalize ações de impacto socioambiental com o PiniOn

Quer responder pesquisas e ganhar dinheiro com o PiniOn?

Acreditamos que os verdadeiros protagonistas do futuro são as pessoas.